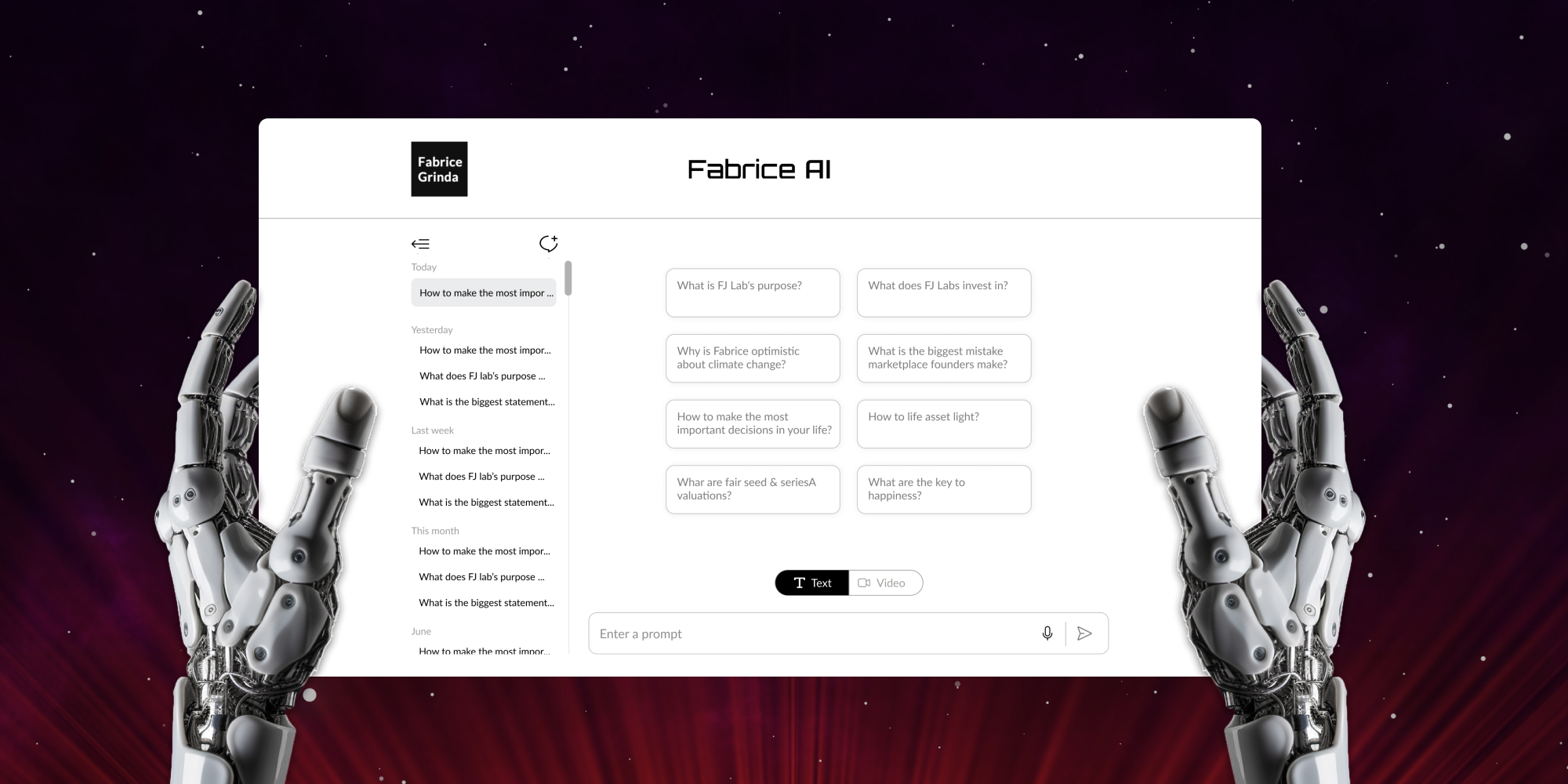

Fabrice AI是基于我博客中所有内容的思想数字化代表。 它旨在成为一个交互式的智能助手,能够理解复杂的询问并做出细致准确的回应。

Fabrice AI 最初是一项实验,是我个人探索人工智能潜力的一次尝试,将我多年来分享的大量知识创建成一个数字版本。 最初,我认为这是一个简单的项目,几个小时就能完成。 计划很简单:将我的内容上传到 OpenAI 的应用程序接口(API)中,让人工智能与之互动,从而创建一个可访问的智能助手,它可以根据我分享的大量信息提供细致入微的答案。

然而,当我踏上这段旅程时,很快就发现这项任务远比我预想的要复杂得多。 我本以为这个项目只是对人工智能的一次短暂尝试,但它却迅速扩展成为一项全面而复杂的工作,所需要的远不止是肤浅的数据上传。 这变成了对人工智能、自然语言处理和知识管理的复杂性的深入研究。

我所面临的核心挑战不仅仅是如何存储信息,而是如何教会人工智能理解信息、将信息与上下文联系起来并准确检索信息,从而反映出我原创内容的深度和细微差别。 这需要采取多方面的方法,因为我发现简单的数据存储和检索方法不足以应对我希望 Fabrice AI 处理的复杂问题。

这一路上,我经历了各种各样的方法,从最初尝试使用矢量搜索索引,到涉及知识图谱、元数据检索和定制人工智能模型的更先进方法。 每种方法都有自己的优缺点,每种方法都让我对人工智能的复杂性和数字知识管理的细微差别有了新的认识。 我将在下一篇博文中详细描述所采取的技术路线。

除了所面临的技术问题之外,生成一个详尽的知识库也具有挑战性。 在测试人工智能准确性的早期阶段,我突然发现,对某些问题最详细、最准确的回答是我在视频访谈或 podcast 中给出的答案。 为了做到准确无误,我需要知识库包含我的所有文章、视频采访、播客、PowerPoint 演示文稿、图片和 PDF 文档。

我首先转录了所有内容。 鉴于自动转录的内容一开始就是近似的,我必须确保人工智能能够理解这些内容。 这需要很长时间,因为我必须测试每一段转录内容的答案。

尽管转录将我和另一位发言者区分开来,但人工智能首先认为 100%的口语内容都是我的,这就需要进行大量的进一步训练,以确保它能正确区分两位发言者的所有内容。 我还希望 Fabrice 人工智能能更重视最近的内容。 当然,我第一次尝试时,它使用的是我将内容上传到 LLM 的日期,而不是我最初发布文章的日期,这需要进一步调整。

为了详尽起见,我还使用 Azure 中的 OCR 模型将我在博客上分享的幻灯片中的知识转录为图片,然后将文件上传到 GPT 助手知识库。 同样,我还从 WordPress 的媒体库中下载了 PDF 文件,并将其上传到知识库中。

在测试期间,我注意到很多朋友提出了博客中没有涉及的个人问题。 我正等待着看大家在接下来几周内提出的问题类型。 如果在我博客的现有内容中找不到答案,我将把答案补充完整。 请注意,我有意将 Fabrice AI 的答案限制在博客内容中,这样您就能真正获得 Fabrice AI,而不是 Fabrice AI 和 Chat GPT 的混合体。

值得一提的是,我是经过一番周折才走到这一步的。 我一开始使用的是 GPT3,但结果令我失望。 尽管有些博客文章的答案与问题完全吻合,但它却一直使用错误的资料来源来回答问题。 尽管我花了几十个小时来解决这个问题,试图让它使用正确的内容(我将在下一篇博文中介绍),但始终没有得到令我满意的结果。

GPT3.5 的情况有所改善,但仍令人失望。 于是,我使用GPT 生成器在GPT Store中创建了一个GPT 应用程序。 它运行得更好一些,操作成本也更低。 不过,我无法让它在我的网站上运行,而且只有 Chat GPT 的付费用户才能使用它,我觉得这太局限了。 无论如何,我不喜欢答案的质量,也不愿意向公众发布。

随着使用 4o 型的GPT 助手的发布,情况有了突破。 我不需要告诉它使用哪些内容,它就能自己解决,一切都变得更好用了。 我放弃了 GPT 应用程序的方法,转而使用应用程序接口,以便将其嵌入博客。 为了详尽起见,我还测试了Gemini,但更喜欢 GPT4o 给出的答案。

我现在发布的是纯文本版本。 它包括语音转文字功能,因此你可以通过语音提问。 我正在想办法编写一个交互式版本,它看起来和听起来都像我,你可以和它进行对话。 我有一个工作原型,但对结果和潜在成本还不太满意。 我想确保它能以第一人称说话,看起来和听起来都像我,而且操作起来不会花很多钱。

我们将拭目以待我在未来几个月中取得的进展,但等待 GPT5 可能更有意义。 事后看来,如果我等到 GPT4o 再开发法布里斯人工智能,就能省下几百个小时的工作量。 话说回来,调查也是重点之一,而且超级有趣。

同时,请使用 Fabrice AI 并告诉我您的想法!