जैसा कि मैंने पिछले पोस्ट में बताया था, फैब्रिस एआई का विकास अपेक्षा से कहीं अधिक जटिल साबित हुआ, जिससे मुझे कई अलग-अलग तरीकों का पता लगाने के लिए मजबूर होना पड़ा।

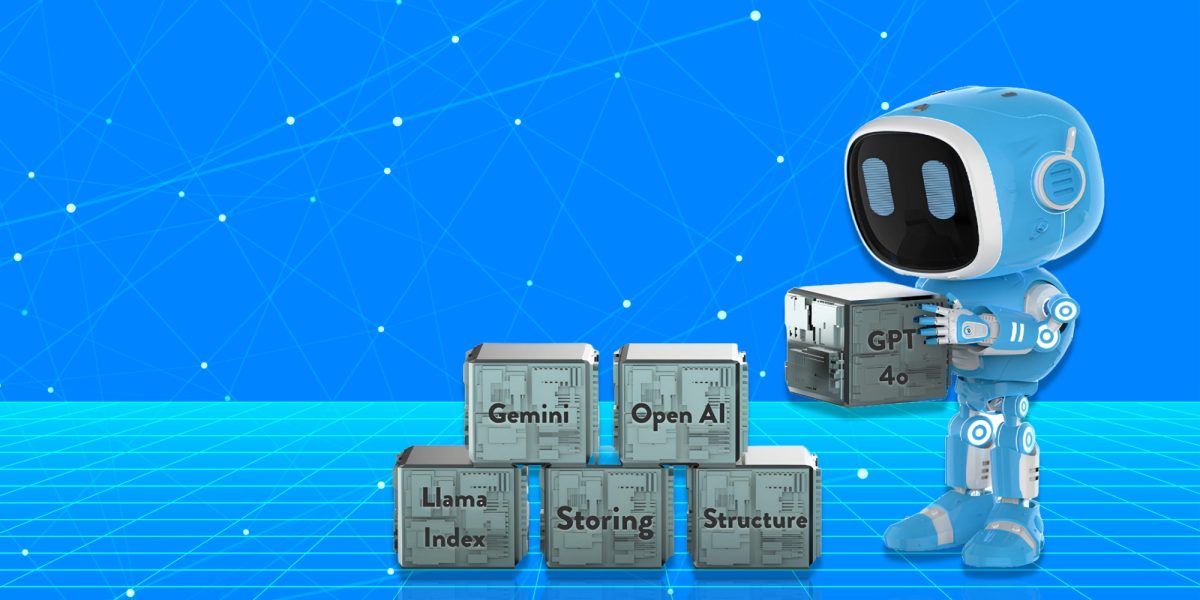

प्रारंभिक दृष्टिकोण: लामा इंडेक्स – वेक्टर खोज

फैब्रिस एआई की पुनर्प्राप्ति क्षमताओं को बढ़ाने में मेरा पहला प्रयास वेक्टर खोज के लिए लामा इंडेक्स का उपयोग करना था। अवधारणा सरल थी: मेरे ब्लॉग से सामग्री लें, इसे लैंगचेन दस्तावेज़ों में परिवर्तित करें, और फिर इन्हें लामा दस्तावेज़ों में बदल दें। ये लामा दस्तावेज़ फिर एक वेक्टर इंडेक्स में संग्रहीत किए जाएँगे, जिससे मैं प्रासंगिक जानकारी के लिए इस इंडेक्स को क्वेरी कर सकूँगा।

हालाँकि, जब मैंने सिस्टम का परीक्षण करना शुरू किया, तो यह स्पष्ट हो गया कि यह दृष्टिकोण मुझे अपेक्षित परिणाम नहीं दे रहा था। विशेष रूप से, जब मैंने सिस्टम से संदर्भ-भारी प्रश्न पूछे जैसे कि “मार्केटप्लेस संस्थापक सबसे बड़ी गलतियाँ क्या करते हैं?” तो AI सार्थक उत्तर देने में विफल रहा। डेटा में अंतर्निहित सूक्ष्म सामग्री को पुनः प्राप्त करने के बजाय, यह अप्रासंगिक या अधूरे उत्तर लौटाता था।

इस शुरुआती विफलता ने मुझे अपने दृष्टिकोण पर पुनर्विचार करने के लिए प्रेरित किया। मुझे एहसास हुआ कि केवल वेक्टर इंडेक्स में सामग्री संग्रहीत करना पर्याप्त नहीं था; पूछे जा रहे प्रश्नों के संदर्भ और बारीकियों को समझने के लिए पुनर्प्राप्ति तंत्र की आवश्यकता थी। यह अहसास कई पाठों में से पहला था जिसने फैब्रिस एआई के विकास को आकार दिया।

ज्ञान संग्रहण: MongoDB दस्तावेज़ संग्रहण और पुनर्प्राप्ति

लामा इंडेक्स दृष्टिकोण की सीमाओं को ध्यान में रखते हुए, मैंने आगे लामा दस्तावेजों को MongoDB में संग्रहीत करने का प्रयास किया। MongoDB की लचीली स्कीमा और दस्तावेज़-उन्मुख संरचना मुझे वर्षों से एकत्रित की गई विविध प्रकार की सामग्री के प्रबंधन के लिए एक आशाजनक समाधान की तरह लगी।

योजना एक अधिक गतिशील और उत्तरदायी खोज अनुभव बनाने की थी। हालाँकि, यह दृष्टिकोण जल्दी ही समस्याओं में बदल गया। खोज कार्यक्षमता, जिसके बारे में मैंने अधिक मज़बूत होने की उम्मीद की थी, अपेक्षा के अनुसार प्रदर्शन करने में विफल रही। क्वेरीज़ जो प्रासंगिक दस्तावेज़ लौटाने चाहिए थे, वे कोई परिणाम नहीं दे रही थीं या अप्रासंगिक सामग्री दे रही थीं।

यह झटका निराशाजनक था, लेकिन इसने एक महत्वपूर्ण सबक भी रेखांकित किया: संग्रहण विधि पुनर्प्राप्ति रणनीति जितनी ही महत्वपूर्ण है। मैंने अन्य विकल्पों पर विचार करना शुरू कर दिया, जैसे कि वेक्टर खोजों के लिए MongoDB एटलस का उपयोग करना, जो संभावित रूप से मुझे आवश्यक सटीकता और मापनीयता प्रदान कर सकता है। हालाँकि, इस विकल्प को अपनाने से पहले, मैं यह निर्धारित करने के लिए अन्य तरीकों का पता लगाना चाहता था कि क्या कोई अधिक प्रभावी समाधान हो सकता है।

मेटाडेटा रिट्रीवर और वेक्टर स्टोर: विशिष्टता की तलाश

मैंने जो अगले रास्ते खोजे, उनमें से एक वेक्टर स्टोर के साथ संयुक्त मेटाडेटा रिट्रीवर का उपयोग था। इस दृष्टिकोण के पीछे का विचार फैब्रिस एआई के भीतर सूचनाओं की विशाल सरणी को वर्गीकृत करना और फिर इन श्रेणियों के आधार पर उत्तर प्राप्त करना था। मेटाडेटा के साथ डेटा को संरचित करके, मुझे उम्मीद थी कि एआई की विशिष्ट, लक्षित उत्तर प्रदान करने की क्षमता में सुधार होगा।

फिर भी, इस पद्धति की अपनी सीमाएँ भी थीं। हालाँकि यह सतह पर आशाजनक लग रहा था, लेकिन AI सभी प्रकार के प्रश्नों के सटीक उत्तर देने में संघर्ष कर रहा था। उदाहरण के लिए, जब मैंने पूछा, “क्या लेखक आशावादी है?” सिस्टम प्रासंगिक सामग्री के संदर्भ में प्रश्न की व्याख्या करने में विफल रहा। मेटाडेटा के आधार पर एक व्यावहारिक विश्लेषण प्रदान करने के बजाय, इसने या तो अस्पष्ट उत्तर दिए या कोई भी नहीं दिया।

इस दृष्टिकोण ने मुझे AI में संदर्भ के महत्व के बारे में एक मूल्यवान सबक सिखाया। केवल जानकारी को वर्गीकृत करना ही पर्याप्त नहीं है; AI को यह भी समझना चाहिए कि ये श्रेणियाँ किस तरह परस्पर क्रिया करती हैं और सामग्री की एक सुसंगत समझ बनाने के लिए ओवरलैप करती हैं। समझ की इस गहराई के बिना, सबसे परिष्कृत पुनर्प्राप्ति विधियाँ भी कम पड़ सकती हैं।

ज्ञान संरचना: सारांश वृक्ष सूचकांक

जैसे-जैसे मैं फैब्रिस एआई को परिष्कृत करता गया, मैंने एक सारांश ट्री इंडेक्स बनाने का प्रयोग किया। इस दृष्टिकोण का उद्देश्य सभी दस्तावेजों को एक वृक्ष प्रारूप में सारांशित करना था, जिससे एआई इन सारांशों के माध्यम से नेविगेट कर सके और सामग्री की संरचना के आधार पर प्रासंगिक जानकारी प्राप्त कर सके।

विचार यह था कि दस्तावेजों का सारांश बनाकर, AI मुख्य बिंदुओं को जल्दी से पहचान सकता है और संक्षिप्त, सटीक जानकारी के साथ प्रश्नों का उत्तर दे सकता है। हालाँकि, इस पद्धति को भी महत्वपूर्ण चुनौतियों का सामना करना पड़ा। AI को जटिल प्रश्नों के सार्थक उत्तर देने में संघर्ष करना पड़ा, जैसे कि “जीवन में महत्वपूर्ण निर्णय कैसे लें?” सारांशों में संग्रहीत समृद्ध, सूक्ष्म सामग्री से आकर्षित होने के बजाय, AI की प्रतिक्रियाएँ अक्सर उथली या अधूरी होती थीं।

इस अनुभव ने AI में चौड़ाई और गहराई के बीच संतुलन बनाने की कठिनाई को रेखांकित किया। जबकि सारांश उच्च-स्तरीय अवलोकन प्रदान कर सकते हैं, उनमें अक्सर अधिक जटिल प्रश्नों के उत्तर देने के लिए आवश्यक विस्तृत संदर्भ का अभाव होता है। मुझे एहसास हुआ कि किसी भी प्रभावी समाधान के लिए विस्तृत सामग्री और उच्च-स्तरीय सारांश दोनों को एकीकृत करने की आवश्यकता होगी, जिससे AI को आवश्यकतानुसार दोनों का उपयोग करने की अनुमति मिल सके।

यही कारण है कि फैब्रिस एआई के वर्तमान संस्करण में, मैंने एआई को पहले उत्तर का सारांश देने को कहा है, उसके बाद अधिक विवरण में जाने को कहा है।

विस्तृत क्षितिज: ज्ञान ग्राफ सूचकांक

पिछले तरीकों की सीमाओं को पहचानते हुए, मैंने एक अधिक परिष्कृत दृष्टिकोण की ओर रुख किया: नॉलेज ग्राफ इंडेक्स। इस दृष्टिकोण में असंरचित पाठ से ज्ञान ग्राफ का निर्माण करना शामिल था, जिससे AI को इकाई-आधारित क्वेरी में संलग्न होने में सक्षम बनाया जा सके। लक्ष्य सामग्री की अधिक गतिशील और परस्पर जुड़ी समझ बनाना था, जिससे फैब्रिस AI जटिल, संदर्भ-भारी प्रश्नों का अधिक प्रभावी ढंग से उत्तर दे सके।

अपने वादे के बावजूद, नॉलेज ग्राफ इंडेक्स को भी महत्वपूर्ण बाधाओं का सामना करना पड़ा। AI को सटीक परिणाम देने में संघर्ष करना पड़ा, खासकर उन प्रश्नों के लिए जिनके लिए संदर्भ की गहरी समझ की आवश्यकता थी। उदाहरण के लिए, जब पूछा गया, “उचित सीड और सीरीज ए मूल्यांकन क्या हैं?” तो AI फिर से प्रासंगिक उत्तर देने में विफल रहा, जिससे असंरचित पाठ को सुसंगत ज्ञान ग्राफ में एकीकृत करने की कठिनाई पर प्रकाश डाला गया।

यह दृष्टिकोण, हालांकि अंततः असफल रहा, लेकिन AI में ज्ञान ग्राफ का उपयोग करने की चुनौतियों में महत्वपूर्ण अंतर्दृष्टि प्रदान करता है। डेटा की जटिलता और सटीक संदर्भ की आवश्यकता का मतलब था कि एक अच्छी तरह से निर्मित ज्ञान ग्राफ भी वांछित परिणाम देने के लिए संघर्ष कर सकता है। नॉलेज ग्राफ इंडेक्स के साथ एक और कमी इसकी धीमी गति थी। संबंधित दस्तावेज़ प्राप्त करने का प्रतिक्रिया समय वेक्टर स्टोर इंडेक्स के सापेक्ष बहुत अधिक था।

डेटा का पुनर्मूल्यांकन: जेमिनी

कई असफलताओं के बाद, मैंने Google के AI, Gemini का लाभ उठाकर एक अलग दृष्टिकोण अपनाने का फैसला किया। विचार JSON-CSV फ़ाइलों से डेटासेट बनाना और फिर इस डेटा का उपयोग करके एक कस्टम मॉडल LLM को प्रशिक्षित करना था। मुझे उम्मीद थी कि संरचित डेटा और एक मजबूत प्रशिक्षण मॉडल का उपयोग करके, मैं उन चुनौतियों में से कुछ को दूर कर सकता हूँ जो पिछले प्रयासों में बाधा बनी थीं।

हालाँकि, इस दृष्टिकोण में भी कठिनाइयाँ आईं। गलत डेटा फ़ॉर्मेटिंग के कारण प्रशिक्षण प्रक्रिया रुक गई, जिससे मॉडल को प्रभावी ढंग से प्रशिक्षित होने से रोका गया। इस झटके ने AI प्रशिक्षण में डेटा अखंडता के महत्व को रेखांकित किया। उचित रूप से फ़ॉर्मेट और संरचित डेटा के बिना, सबसे उन्नत मॉडल भी अपेक्षित प्रदर्शन करने में विफल हो सकते हैं।

इस अनुभव ने मुझे JSON डेटा को संग्रहीत करने के लिए BigQuery का उपयोग करने की क्षमता पर विचार करने के लिए प्रेरित किया, जिससे फैब्रिस AI को प्रभावी ढंग से प्रशिक्षित करने के लिए आवश्यक बड़े डेटासेट के प्रबंधन के लिए अधिक स्केलेबल और विश्वसनीय प्लेटफ़ॉर्म प्रदान किया जा सके।

शक्तियों का संयोजन: पाइनकोन के साथ लैंगचेन दस्तावेज़

अब तक की चुनौतियों के बावजूद, मैं एक ऐसा समाधान खोजने के लिए दृढ़ था जो फैब्रिस एआई को प्रभावी रूप से ज्ञान को संग्रहीत और पुनर्प्राप्त करने की अनुमति देगा। इस दृढ़ संकल्प ने मुझे लैंगचेन दस्तावेज़ों और पाइनकोन के साथ प्रयोग करने के लिए प्रेरित किया। इस दृष्टिकोण में लैंगचेन दस्तावेज़ों और ओपनएआई एम्बेडिंग का उपयोग करके पाइनकोन वेक्टर स्टोर बनाना, फिर क्वेरी के आधार पर शीर्ष समान दस्तावेज़ों को पुनर्प्राप्त करना शामिल था।

इस पद्धति ने आशाजनक परिणाम दिखाए, खासकर तब जब क्वेरी में दस्तावेज़ का शीर्षक शामिल था। उदाहरण के लिए, जब पूछा गया, “खुशी की कुंजी क्या है?” तो AI प्रासंगिक सामग्री को सटीक रूप से प्राप्त करने और सारांशित करने में सक्षम था। हालाँकि, अभी भी सीमाएँ थीं, खासकर जब क्वेरी में विशिष्ट कीवर्ड या शीर्षकों का अभाव था।

इस दृष्टिकोण ने AI प्रदर्शन को बढ़ाने के लिए विभिन्न तकनीकों के संयोजन की क्षमता को प्रदर्शित किया। लैंगचेन दस्तावेज़ों को पाइनकॉन के वेक्टर स्टोर के साथ एकीकृत करके, मैं AI की प्रतिक्रियाओं की प्रासंगिकता और सटीकता में सुधार करने में सक्षम था, हालाँकि कुछ सीमाओं के साथ।

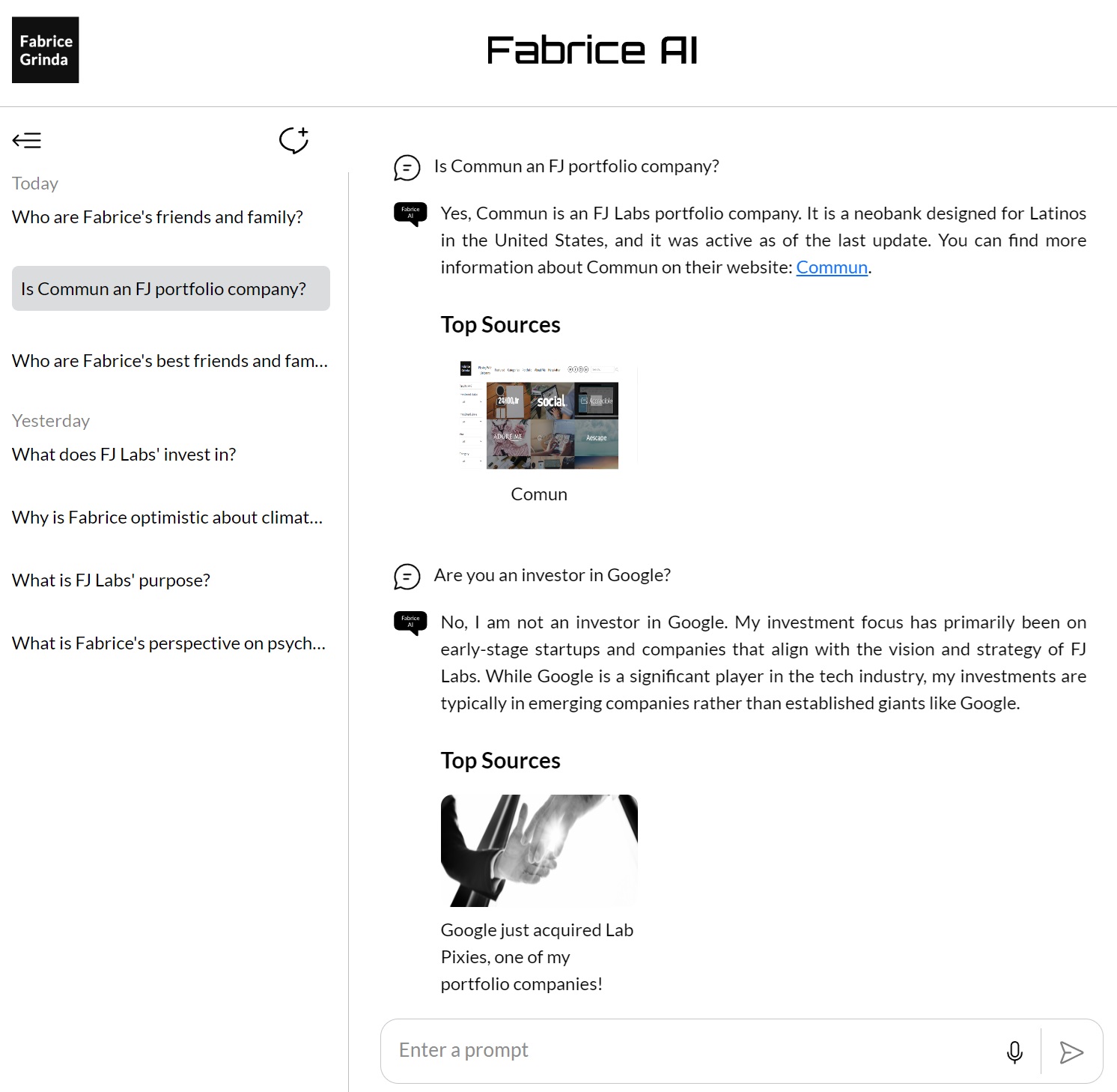

स्थिरता प्राप्त करना: GPT बिल्डर OpenAI

विभिन्न तरीकों और तकनीकों की खोज करने के बाद, मैंने फैब्रिस एआई में संग्रहीत ज्ञान को समेकित और परिष्कृत करने के लिए ओपन एआई के जीपीटी बिल्डर की ओर रुख किया। सभी सामग्री को जीपीटी ज्ञान आधार में अपलोड करके, मेरा लक्ष्य अपने ज्ञान को पुनः प्राप्त करने और उससे बातचीत करने के लिए एक अधिक सुसंगत और विश्वसनीय मंच बनाना था।

यह दृष्टिकोण सबसे सफल साबित हुआ, जिसमें AI कई तरह के प्रश्नों में बेहतर परिणाम देने में सक्षम था। इस सफलता की कुंजी सभी ज्ञान को एक एकल, सुसंगत प्रणाली में एकीकृत करना था, जिससे AI को प्रश्नों का उत्तर देते समय सामग्री की पूरी चौड़ाई का उपयोग करने की अनुमति मिलती थी।

जैसा कि मेरी पिछली पोस्ट में बताया गया है, मैं इसे अपनी वेबसाइट पर नहीं चला पाया, और यह केवल चैट GPT के सशुल्क ग्राहकों के लिए उपलब्ध था, जो मुझे लगा कि बहुत सीमित था। साथ ही, जबकि यह बेहतर था, फिर भी मुझे उत्तरों की गुणवत्ता पसंद नहीं आई और इसे सार्वजनिक रूप से जारी करने में सहज नहीं था।

अंतिम परिशोधन: मॉडल 4o का उपयोग करने वाले GPT सहायक

फैब्रिस एआई को विकसित करने में पहेली का अंतिम टुकड़ा मॉडल 4o का उपयोग करके जीपीटी सहायकों की शुरूआत के साथ आया। यह दृष्टिकोण पूरे प्रोजेक्ट में मैंने जो कुछ भी सीखा था, उसकी परिणति का प्रतिनिधित्व करता है। वेक्टर डेटाबेस का उपयोग करके और संकेतों को परिष्कृत करके, मेरा लक्ष्य एआई की प्रतिक्रियाओं में सटीकता और प्रासंगिक समझ के उच्चतम संभव स्तर को प्राप्त करना था।

इस विधि में मेरे द्वारा एकत्रित सभी ज्ञान को एक वेक्टर डेटाबेस में अपलोड करना शामिल था, जिसे तब AI की अंतःक्रियाओं के लिए आधार के रूप में उपयोग किया गया था। वेक्टर डेटाबेस ने AI को अधिक परिष्कृत खोज करने की अनुमति दी, केवल कीवर्ड मिलान पर निर्भर रहने के बजाय प्रश्नों के अर्थपूर्ण अर्थ के आधार पर जानकारी प्राप्त की। यह पिछले तरीकों की तुलना में एक महत्वपूर्ण प्रगति को चिह्नित करता है, जिससे AI को जटिल, सूक्ष्म प्रश्नों को बेहतर ढंग से समझने और उनका जवाब देने में सक्षम बनाया गया।

इस दृष्टिकोण के प्रमुख नवाचारों में से एक प्रॉम्प्ट का सावधानीपूर्वक परिशोधन था। अलग-अलग प्रॉम्प्ट को सावधानीपूर्वक तैयार करके और उनका परीक्षण करके, मैं AI को अधिक सटीक और प्रासंगिक उत्तर प्रदान करने की दिशा में मार्गदर्शन करने में सक्षम था। इसमें न केवल प्रॉम्प्ट के शब्दों को बदलना शामिल था, बल्कि सर्वोत्तम संभव प्रतिक्रियाएँ प्राप्त करने के लिए प्रश्नों को संरचित करने के विभिन्न तरीकों के साथ प्रयोग करना भी शामिल था।

परिणाम प्रभावशाली थे। AI अब उच्च सटीकता के साथ प्रश्नों की एक विस्तृत श्रृंखला को संभालने में सक्षम था, तब भी जब प्रश्न खुले-आम थे या संदर्भ की गहरी समझ की आवश्यकता थी। उदाहरण के लिए, जब पूछा गया, “अपने जीवन में सबसे महत्वपूर्ण निर्णय कैसे लें?” AI ने एक व्यापक और व्यावहारिक उत्तर दिया, जिसमें एक अच्छी तरह से गोल प्रतिक्रिया देने के लिए विभिन्न स्रोतों और दृष्टिकोणों का उपयोग किया गया।

यह सफलता सैकड़ों घंटों की मेहनत और अनगिनत प्रयोगों का परिणाम थी। इसने प्रदर्शित किया कि, प्रौद्योगिकी और परिशोधन के सही संयोजन के साथ, एक ऐसा AI बनाना संभव था जो न केवल सूचना को प्रभावी ढंग से संग्रहीत और पुनर्प्राप्त कर सके बल्कि सार्थक तरीके से उससे जुड़ भी सके। मॉडल 4o का उपयोग करके GPT सहायकों के विकास ने उस बिंदु को चिह्नित किया, जिस पर फैब्रिस AI वास्तव में अपनी पहचान बना पाया, जिसने उस स्तर की परिष्कार और सटीकता हासिल की जिसकी मैंने शुरुआत से ही कल्पना की थी। GPT सहायक API को तब मेरे ब्लॉग में एकीकृत किया गया था ताकि अंतिम उपयोगकर्ता फैब्रिस AI के साथ उसी तरह से बातचीत कर सकें जिस तरह से आप इसे अभी ब्लॉग पर देखते हैं।

यात्रा पर चिंतन

फैब्रिस एआई को विकसित करने की प्रक्रिया ने एआई के साथ काम करने की जटिलताओं को उजागर किया, खासकर जब जानकारी को समझने और संदर्भ देने की बात आती है। इसने मुझे सिखाया कि एआई विकास में कोई शॉर्टकट नहीं है – हर कदम, हर पुनरावृत्ति और हर प्रयोग वास्तव में प्रभावी कुछ बनाने की दिशा में यात्रा का एक आवश्यक हिस्सा है।

भविष्य को देखते हुए, मैं फैब्रिस एआई को परिष्कृत और विस्तारित करना जारी रखने के लिए उत्साहित हूं। जैसा कि पिछली पोस्ट में बताया गया है, मैं ज्ञान के आधार को पूरा करने के लिए पूछे गए प्रश्नों की समीक्षा करूंगा, जहां अंतराल हैं। मैं अंततः एक इंटरैक्टिव संस्करण जारी करने की भी उम्मीद कर रहा हूं जो दिखने और सुनने में मेरे जैसा हो और जिससे आप बात कर सकें।